HDFS ACL权限设置

HDFS版本:3.1.1

今天主要给大家说一下HDFS文件权限的问题。当一个普通用户去访问HDFS文件时,可能会报Permission denied的错误。那么你会怎么做呢?

像修改linux文件似的,可能的做法有:

- 修改文件所有者

- 直接将文件赋予全部的权限,即rwx权限。

上面的做法虽然可以达到目的,但是相对来说对权限的把握不是很精准,不适用于生产环境。

本文主要讲解HDFS的ACL(Access Control List)权限,通过hdfs超级用户,来为普通用户分配权限。

一、背景

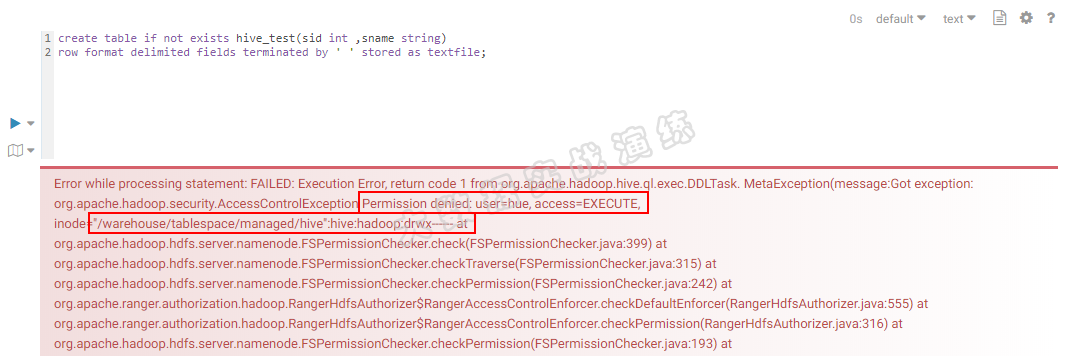

如下图所示,我使用hue用户想创建一个简单的hive表。由于hue用户对/warehouse/tablespace/managed/hive目录没有权限,所以创建失败了。

这里就用到了HDFS的ACL权限设置。

二、前提条件

需要确定hdfs-site.xml文件的两个配置项为true:

1 | <property> |

三、语法

1. setfacl

1 | Usage: hdfs dfs -setfacl -R|[--set <acl_spec> <path>] |

设置文件和目录的访问控制列表(ACL)。

选项:

- -b: 删除基本ACL条目以外的所有条目。保留用户,组和其他条目以与权限位兼容。

- -k: 删除默认ACL。default

- -R: 以递归方式将操作应用于所有文件和目录。常用。

- -m: 修改ACL。新条目将添加到ACL,并保留现有条目。常用。

- -x: 删除指定的ACL条目。保留其他ACL条目。常用。

- –set: 完全替换ACL,丢弃所有现有条目。 acl_spec必须包含用户,组和其他条目,以便与权限位兼容。

- acl_spec: 逗号分隔的ACL条目列表。

- path: 要修改的文件或目录。

示例:

- hdfs dfs -setfacl -m user:hadoop:rw- /file

- hdfs dfs -setfacl -x user:hadoop /file

- hdfs dfs -setfacl -b /file

- hdfs dfs -setfacl -k /dir

- hdfs dfs -setfacl –set user::rw-,user:hadoop:rw-,group::r–,other::r– /file

- hdfs dfs -setfacl -R -m user:hadoop:r-x /dir

- hdfs dfs -setfacl -m default:user:hadoop:r-x /dir

2. getfacl

1 | Usage: hdfs dfs -getfacl [-R] <path> |

显示文件和目录的访问控制列表(ACL)。如果目录具有默认ACL,则getfacl还会显示默认ACL。

选项:

- -R: 以递归方式列出所有文件和目录的ACL。

- path: 要列出的文件或目录。

示例:

- hdfs dfs -getfacl /file

- hdfs dfs -getfacl -R /dir

四、为hue用户赋予权限

使用hdfs超级用户来设置acl:使用-m参数

1 | sudo -u hdfs hdfs dfs -setfacl -m user:hue:rwx /warehouse/tablespace/managed/hive |

查看文件目录的acl权限:

1 | hdfs dfs -getfacl /warehouse/tablespace/managed/hive |

文件acl权限如下图所示:

现在hue用户就对/warehouse/tablespace/managed/hive这个目录有了rwx全部权限了。

我们使用hue用户创建hive表试试,成功了,如下图所示:

备注:

不过是仅限于hive这个目录,对于里面不是hue用户创建的目录或文件,hue用户还是无权访问。

如果需要访问递归的子文件,可以使用-R参数,再次授权。

五、总结

其实这次分享的知识点很简单,但是却很实用。就安全的角度来看,比起chmod 777来说,也比较严谨。

还是希望大家多多练习本文讲述的两个命令:

- setfacl

- getfacl

看看这两个命令的其它参数具体什么意思。

关于HDFS shell命令,可以查看官网链接:http://hadoop.apache.org/docs/r2.6.5/hadoop-project-dist/hadoop-common/FileSystemShell.html,晚安💗

点关注,不迷路

好了各位,以上就是这篇文章的全部内容了,能看到这里的人呀,都是人才。

白嫖不好,创作不易。各位的支持和认可,就是我创作的最大动力,我们下篇文章见!

如果本篇博客有任何错误,请批评指教,不胜感激 !

原文作者: create17

原文链接: https://841809077.github.io/2019/03/16/HDFS/HDFS-ACL权限设置.html

版权声明: 转载请注明出处(码字不易,请保留作者署名及链接,谢谢配合!)